### 前言

在当今数字化时代,数据分析和预测已成为各行各业不可或缺的工具。无论是金融市场的波动预测,还是体育赛事的结果分析,准确的数据模型和预测方法都能为我们提供宝贵的决策支持。今天,我们将深入探讨一个备受关注的话题——“澳门一码一肖一待一中今晚”,并以此为切入点,详细介绍如何利用数据分析和统计学原理来提高预测的准确性。

无论你是初学者还是进阶用户,本文都将为你提供一套系统化的步骤指南,帮助你掌握这一技能。我们将从基础的数据收集开始,逐步深入到数据处理、模型构建和结果分析,确保每个步骤都清晰易懂,并配有实际示例。通过本文的学习,你将能够独立完成数据预测任务,并在实际应用中不断提升自己的技能。

### 第一步:数据收集

数据收集是任何数据分析项目的基础。没有高质量的数据,后续的所有分析都将失去意义。在这一步中,我们将详细介绍如何有效地收集与“澳门一码一肖一待一中今晚”相关的数据。

#### 1.1 确定数据来源

首先,你需要明确数据的来源。对于“澳门一码一肖一待一中今晚”这一主题,数据可能来自以下几个渠道:

- **官方网站**:澳门特别行政区政府或相关机构的官方网站通常会发布最新的数据和统计信息。

- **第三方数据平台**:一些专业的数据平台,如Bloomberg、Reuters等,也会提供相关的历史数据和实时数据。

- **社交媒体和论坛**:有时,社交媒体和论坛上的讨论和用户生成内容也能提供有价值的信息。

#### 1.2 选择合适的数据类型

在确定了数据来源后,你需要选择合适的数据类型。对于“澳门一码一肖一待一中今晚”这一主题,你可能需要收集以下几类数据:

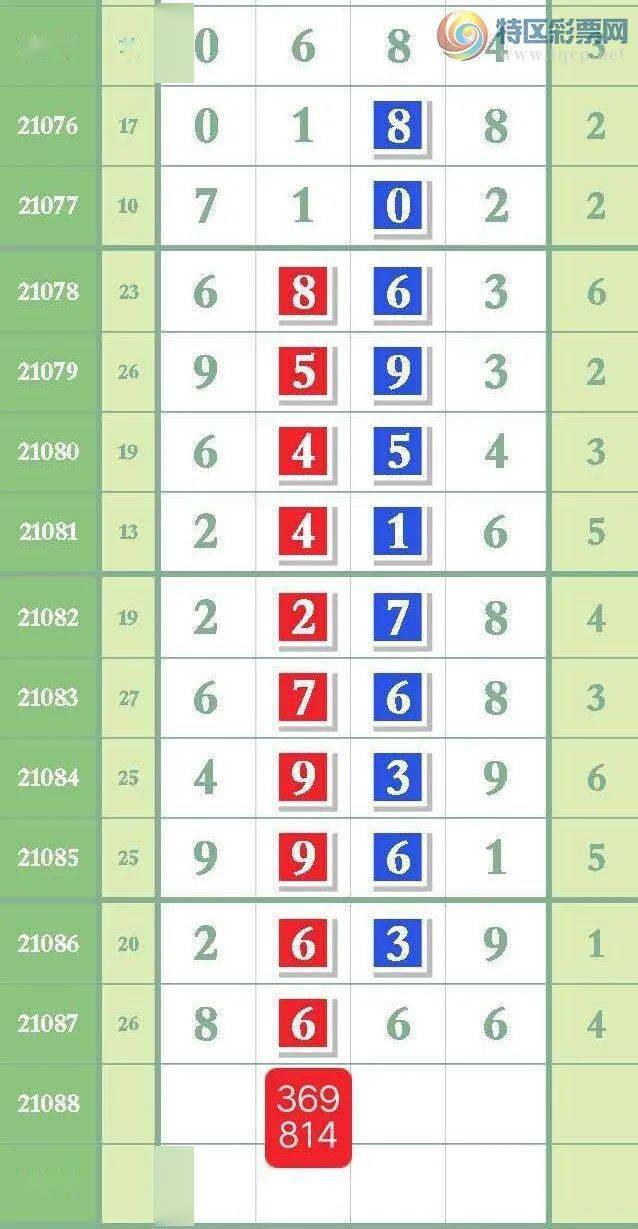

- **历史数据**:包括过去一段时间内的开奖结果、中奖号码等。

- **实时数据**:包括当前的开奖情况、赔率变化等。

- **外部数据**:如经济指标、天气数据等,这些数据可能对预测结果有间接影响。

#### 1.3 数据收集工具

为了高效地收集数据,你可以使用以下工具:

- **网络爬虫**:如果你需要从网页上自动抓取数据,可以使用Python的BeautifulSoup或Scrapy库。

- **API接口**:许多数据平台提供API接口,你可以通过编程方式直接获取数据。

- **手动记录**:对于一些无法自动获取的数据,你可能需要手动记录。

#### 示例

假设你选择从澳门特别行政区政府的官方网站收集历史开奖数据。你可以使用Python编写一个简单的爬虫脚本,自动抓取网页上的数据并保存到本地文件中。

```python

import requests

from bs4 import BeautifulSoup

url = "https://www.example.gov.mo/lottery"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 假设数据在表格中

table = soup.find('table')

rows = table.find_all('tr')

data = []

for row in rows:

cols = row.find_all('td')

cols = [col.text.strip() for col in cols]

data.append(cols)

# 保存到CSV文件

import csv

with open('lottery_data.csv', 'w', newline='') as f:

writer = csv.writer(f)

writer.writerows(data)

```

### 第二步:数据清洗

收集到的数据往往包含噪声和错误,因此在进行分析之前,必须进行数据清洗。数据清洗的目的是确保数据的准确性和一致性,为后续的分析打下坚实的基础。

#### 2.1 检查数据完整性

首先,你需要检查数据的完整性。缺失值和异常值是常见的数据问题,可能会影响分析结果。你可以使用以下方法来检查数据完整性:

- **缺失值检测**:使用Python的Pandas库可以轻松检测数据中的缺失值。

- **异常值检测**:通过统计方法或可视化工具(如箱线图)来识别异常值。

#### 2.2 处理缺失值

对于缺失值,你可以选择以下几种处理方法:

- **删除缺失值**:如果缺失值较少,可以直接删除这些记录。

- **填充缺失值**:使用均值、中位数或插值法来填充缺失值。

- **标记缺失值**:将缺失值标记为特殊值,以便在后续分析中进行处理。

#### 2.3 处理异常值

异常值的处理方法包括:

- **删除异常值**:如果异常值是由数据录入错误引起的,可以直接删除。

- **修正异常值**:如果异常值是合理的,但偏离了正常范围,可以对其进行修正。

- **标记异常值**:将异常值标记为特殊值,以便在后续分析中进行处理。

#### 示例

假设你在第一步中收集到的数据包含缺失值和异常值。你可以使用Pandas库来处理这些问题。

```python

import pandas as pd

# 读取CSV文件

data = pd.read_csv('lottery_data.csv')

# 检查缺失值

print(data.isnull().sum())

# 填充缺失值

data['column_name'].fillna(data['column_name'].mean(), inplace=True)

# 检查异常值

import seaborn as sns

sns.boxplot(x=data['column_name'])

# 处理异常值

Q1 = data['column_name'].quantile(0.25)

Q3 = data['column_name'].quantile(0.75)

IQR = Q3 - Q1

data = data[(data['column_name'] >= Q1 - 1.5*IQR) & (data['column_name'] <= Q3 + 1.5*IQR)]

```

### 第三步:数据预处理

数据预处理是数据分析中的关键步骤,它包括数据转换、标准化和特征工程等操作。通过数据预处理,你可以将原始数据转换为适合分析的形式,从而提高模型的准确性。

#### 3.1 数据转换

数据转换的目的是将数据转换为更适合分析的形式。常见的数据转换方法包括:

- **归一化**:将数据缩放到一个固定的范围(如0到1)。

- **标准化**:将数据转换为均值为0,标准差为1的分布。

- **对数转换**:适用于数据分布偏斜的情况。

#### 3.2 特征工程

特征工程是指从原始数据中提取有用的特征,以提高模型的性能。常见的特征工程方法包括:

- **特征选择**:选择对预测结果影响最大的特征。

- **特征组合**:将多个特征组合成新的特征。

- **特征编码**:将分类变量转换为数值变量。

#### 3.3 数据分割

在构建模型之前,你需要将数据集分为训练集和测试集。训练集用于训练模型,测试集用于评估模型的性能。常见的数据分割方法包括:

- **随机分割**:将数据随机分为训练集和测试集。

- **时间序列分割**:适用于时间序列数据,确保测试集的时间点在训练集之后。

#### 示例

假设你已经完成了数据清洗,接下来需要进行数据预处理。你可以使用Pandas和Scikit-learn库来完成这些操作。

```python

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.model_selection import train_test_split

# 归一化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data[['numeric_column']])

# 特征编码

encoder = OneHotEncoder()

data_encoded = encoder.fit_transform(data[['categorical_column']])

# 数据分割

X = data[['numeric_column', 'categorical_column']]

y = data['target_column']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

### 第四步:模型选择与构建

在数据预处理完成后,你可以开始选择和构建模型。模型的选择取决于数据的类型和分析的目标。在这一步中,我们将介绍几种常见的模型,并详细说明如何构建和训练这些模型。

#### 4.1 模型选择

根据“澳门一码一肖一待一中今晚”这一主题,你可能需要选择以下几种模型:

- **线性回归**:适用于预测连续变量

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...